Resumen

El hombre siempre se ha enfrentado al reto de la supervivencia, para ello el análisis de la información y las predicciones han sido esenciales, pero también su aporte como individuo a su comunidad. Los desarrollos tecnológicos inicialmente primitivos, casi intuitivos como el ábaco o la observación de los fenómenos naturales han evolucionado hoy a un componente híbrido generado por el surgimiento de la Inteligencia Artificial (IA).

En este artículo describimos la línea del tiempo de la IA con enfoque en el campo de la medicina; la evolución de los modelos lógicos y matemáticos subyacentes al aprendizaje automatizado (AA) y al aprendizaje profundo (DL), con el fin de explicar al lector cómo se ha construido este interesante campo cuya evolución ha sido fantástica y necesaria para optimizar lo que conocemos como medicina, pero especialmente para hacernos mejores seres humanos.

Palabras clave: Inteligencia artificial; máquinas de turing; modelo perceptrón; IBM Watson; chatbot; redes bayesianas; redes neuronales profundas.

From Abacus to Neural Networks or the Brief History of Artificial Intelligence in Health

Abstract

Human has always faced the challenge of survival, for this reason, the analysis of information and predictions have been essential, but also his contribution as an individual to his community. Primitive, almost intuitive technological developments such as the abacus or the observation of natural phenomena have evolved today to a hybrid component generated by the creation of Artificial Intelligence (AI).

This article describes the timeline of AI with a focus on the field of medicine and likewise describes the evolution of the logical and mathematical models underlying machine learning (ML) and deep learning (DL) trying to explain how this interesting field has been built, and whose evolution has been fantastic and necessary to optimize what we know as medicine, but especially to make us better human beings.

Keywords: Artificial Intelligence; Machine learning; Deep learning; Alan turing; Turing´s machines; Perceptron model; IBM Watson; Chatbot; Bayesian networks; Deep neuronal networks.

Introducción – Del Ábaco a las Redes Neuronales o la Breve Historia de la Inteligencia Artificial en Salud

Durante su evolución, el hombre, inicialmente como individuo y después como miembro de una sociedad, ha tenido diferentes retos para garantizar su supervivencia, el mayor de estos ha sido la gestión de la información.

El hombre antiguo debió utilizarla para saber, por ejemplo, el inicio de las migraciones de animales (1) y entonces elegir los momentos para una caza efectiva o la predicción de las lluvias para sembrar y cosechar.

Sin un buen sistema para el manejo de los datos, se cernía una amenaza a su seguridad alimentaria y por ende a la sobrevivencia individual y comunitaria, situación que sigue vigente a nivel mundial (2).

El otro gran reto del hombre ha sido su interacción social y dentro de ella, los modelos de producción y aporte.

Las unidades de dichos modelos llamados trueque, diezmo y posteriormente impuestos, debían soportarse en métodos de cálculo que permitieran ajustar y “predecir” con la mayor exactitud posible lo que unos y otros debían aportar a la sociedad.

Los predecibles errores de los sistemas antiguos de cálculo, reflejados en pérdidas de datos e inexactitudes, fueron transversales a las diferentes culturas y sociedades (precolombina, colonial, posindependencia, posrevolución industrial y presente).

Como respuestas a estas necesidades surgieron diferentes sistemas contables, algunos tan antiguos como el Quipu Inca (3,4) o el ábaco chino, cuyo origen se remonta al 300 a.C., con vestigios sobre su uso desde el Sahara hasta el lejano oriente; las calculadoras analógicas que permiten sumar, restar, registrar, calcular cantidades y sus derivadas digitales que en la actualidad permiten la resolución de complejas ecuaciones (5).

Respecto a la necesidad de predecir a través de patrones, las primeras soluciones de las que se tenga documentación, mediante investigaciones antropológicas, son el calendario Maya o el Mecanismo de Anticitara, este último consiste en una serie de engranajes que se ha descrito como la primera computadora analógica del mundo, logrando predecir eventos astronómicos, especialmente los relacionados con los ciclos biológicos y la medición del tiempo (3).

Pero desde el año 200 a.C., que se considera es la fecha de creación del complejo engranaje que predecía el movimiento estelar y planetario en el antiguo Mediterráneo como lo era este mecanismo de Anticitara, o hasta los años 1600 cuando resurge esta tecnología, se inicia un complejo proceso que da paso en el siglo XIX al desarrollo de transistores, que a su vez, son superados por los circuitos integrados que fueron reduciendo su tamaño y que en el siglo XXI preparan la entrada de los procesadores cuánticos a la vida cotidiana de la ciencia y la vida.

La historia de lo que conocemos como Inteligencia Artificial (IA) involucra la historia misma del pensamiento humano y de sus retos.

El surgimiento de la IA y su aplicación en la salud es una historia aún llena más de promesas que de realidades, con un crecimiento exponencial en los últimos 50 años y con -ojalá- promisorio futuro, pero las dinámicas que nos han traído hasta aquí, como veremos, han navegado mucho más en el terreno de la matemática e ingeniería que en el de la medicina y por tanto, uno de los objetivos de esta travesía es impregnar de interés a nuestros lectores en este fantástico mundo.

Para efectos de facilitar este viaje hemos dividido la historia de la IA en cuatro estaciones (6) con las menciones respectivas al desarrollo paralelo en nuestro mundo de la medicina.

La primavera de la IA

Aunque muchos antiguos como Homero con sus trípodes, Julio Verne con sus naves fantásticas y Descartes con su “hombre mecánico” habían soñado previamente con creaciones automatizadas (7), fue solo hasta los años 1900 cuando la aparición de máquinas inteligentes daría mayores posibilidades de llevar este sueño a la realidad.

En 1942 el escritor americano de ciencia ficción -Issac Asimov- publicó su historia Runaround, en la que un robot desarrollado por los ingenieros Gregory Powell y Mike Donovan evoluciona, generando las tres leyes de la robótica:

- Un robot no puede lesionar a un ser humano o dejar que otro lo lesione,

- Un robot debe obedecer las órdenes del humano, excepto que estás vayan en contra de la ley anterior,

- Un robot debe proteger su propia existencia siempre y cuando esto no entre en conflicto con las 2 leyes anteriores.

El trabajo de Asimov inspiró a muchos científicos en los campos de robótica, IA y ciencias de la computación, entre ellos a Marvin Minsky, quien posteriormente fundó el laboratorio de IA en el MIT.

Casi al mismo tiempo, pero en Inglaterra, el científico más relevante en la historia de la IA -Alan Turing-, trabajaba sentando las bases sobre las cuales navegarían los desarrollos secuenciales de esta nueva área del conocimiento.

Debemos entonces hacer una breve revisión de su vida y aportes.

Alan Mathison Turing (1912 – 1954) – Del Ábaco a las Redes Neuronales o la Breve Historia de la Inteligencia Artificial en Salud

Su vida tan fascinante como compleja lo llevó a ser no solamente un científico esencial para el fin de la segunda guerra mundial, como se le reconoce por su desciframiento del famoso código alemán Enigma, sino por su revolucionario análisis de la automatización como concepto, lo que llevaría más tarde a la creación del software, las leyes de la computación y por supuesto a la IA (8) (Figura 1).

Figura 1. Alan Mathison Turing (Tomado de http://www.tecnologiahechapalabra.com/)

Alan provenía de una familia inglesa de modesta distinción. Un ancestro lejano, George Johnstone, bautizó al electrón en 1894.

Su padre, Julius Turing, estuvo la mayor parte del tiempo en servicio social en la India después de su graduación en Oxford. La familia vivía entre ese país y Londres, ciudad en la que nacería Alan un 23 de junio de 1912.

Los padres de Alan decidieron dejar a sus dos hijos al cuidado de la familia del coronel Wards, en una pequeña ciudad cerca de Hastings.

En dicha ciudad creció Alan hasta 1926 cuando fue enviado al internado de Sherborne, uno de los más antiguos en Inglaterra. Alan nunca se sintió muy a gusto en el internado, su debilidad física y bajo rendimiento en áreas diferentes a las ciencias y matemáticas no le hicieron gozar de mucha popularidad.

Cayó enfermo de parotiditis durante su segundo año escolar y tuvo entonces la “fortuna” de estar hospitalizado un buen tiempo, durante el cual leyó los resúmenes de las teorías general y especial de la relatividad de Einstein.

En Sherborne entabló una relación cercana con quien era posiblemente su alter ego, Christopher Morcom:

Un año mayor que él, pero a diferencia de Alan inmensamente popular, y con quien compartía el gusto por las matemáticas.

Cristopher lamentablemente fallece por tuberculosis un año después, lo que sumado a su no ingreso al Trinity College sumieron a Alan en una profunda depresión, superada en 1931 al ingresar al King´s College en Cambridge a estudiar matemáticas.

Su trabajo de graduación sobre el teorema del límite central de probabilidad fue muy meritorio y le ayudó a seguir como profesor en su escuela.

En 1928 David Hilbert relanzó los tres grandes retos de la matemática. Alan se interesó por demostrar la decidibilidad, es decir, demostrar que la ciencia tiene un procedimiento de decisión para definir la veracidad o no de una proposición matemática cualquiera.

Para abordar el reto, Alan decidió expresarlo en términos de máquinas, hoy conocidas como las máquinas de Turing, concepto que unido al álgebra Booleana terminaría más tarde siendo la base de los lenguajes de computación.

Al unir su trabajo con el concepto de la diagonalización de Cantor y la lógica de Alonzo Church, Turing demostró que el procedimiento de decisión no tiene existencia factible en las matemáticas. Este primer trabajo con sus máquinas llevó a Alan a escribir su más famoso artículo: “Sobre números computables con una aplicación”, publicado en 1936 (9). Le puede interesar: La teoría del cuidado humano de Jean Watson.

Este trabajo llamó tanto la atención en el mundo matemático de la época, que el mismo Alonzo Church le ofreció una pasantía en la universidad de Princeton para trabajar con su mentor Max Newman. En 1938 logra su doctorado en matemáticas en Princeton, pero decide regresar a Cambridge.

Septiembre de 1939, al estallar la Segunda Guerra Mundial, Alan es trasladado al proyecto del código Enigma en Bletchley Park:

En donde además conoce a su futura esposa Joane Clarke. Como era de esperarse por las tendencias sexuales de Alan, el matrimonio es un completo fracaso.

Una vez culminado el proyecto Enigma y ya divorciado, Alan tiene en su mente la idea de “construir un cerebro” y sabiendo que en Cambridge la posibilidad de lograrlo era mínima, decide mudarse al laboratorio Nacional de Física en Londres.

Dos años estuvo Turing intentando crear la primera computadora, pero al final decide abandonar el proyecto debido a una alta carga burocrática. Alan entonces regresó a Cambridge.

En su fase final en Cambridge, inició una relación sentimental con uno de sus alumnos, produciendo un gran escándalo en 1952 ya que, con la excusa de un robo, la policía inglesa irrumpió en la casa de Alan descubriendo sus prácticas homosexuales, prohibidas para la época.

Condenado a dos años de terapia de castración farmacológica:

Lo cual le produjo una serie de efectos secundarios que le llevaron a deteriorar su calidad de vida, a tal punto que se suicidó en 1954, siendo una de las mentes más brillantes de la historia, quizás comparable a Newton, Tesla, Einstein o Hawking. Sus teorías subyacen hoy a casi toda la modernidad. No podríamos escribir estas líneas sin la contribución de Turing.

En 1956, seis años después de la publicación del trabajo seminal de Turing, en la ya histórica convención del DSRPAI (Darmouth Summer Research Project on AI) la palabra inteligencia artificial fue adoptada por Marvin Minsky y John McCarthy como “la ciencia y la ingeniería de hacer inteligentes a las máquinas”. En este nacimiento de la IA también participaron el científico de la computación Nathaniel Rochester, quien posteriormente diseñó el primer computador científico comercial, el IBM 701, y el matemático Claude Chan, creador de la teoría de la información.

Verano e inviernos de la IA

Las siguientes dos décadas después de la conferencia de Dartmouth estuvieron llenas de avances significativos en el campo de la IA.

Uno de ellos fue la creación del programa ELIZA en el MIT, el primer procesador de lenguaje natural en la historia. El desarrollo del primer programa de resolución general de problemas creado por Herbert Simon y la corporación RAND, permitió resolver problemas simples como el de las Torres de Hanoi.

Esto llevó a Minsky en 1970 -durante una entrevista a la revista Life- a manifestar que él esperaba la creación de una máquina con una inteligencia promedio, similar a la del humano en los siguientes 3 a 8 años. Esta fase corresponde al verano de la IA.

Sin embargo, en 1973 el congreso americano y el gobierno británico empezaron a criticar el alto gasto que estaba generando la investigación en IA:

Por lo que se frenaron muchos desarrollos en el campo, pero irónicamente se enfocaron estos recursos al proyecto DARPA, que daría origen posteriormente a uno de los desarrollos que mayor crecimiento brindaría a la IA, lo que hoy llamamos la Internet (10).

A este periodo se le conoce como el invierno. Realmente la IA tuvo dos periodos de invierno, el primero en los años 70´s generado por las limitaciones percibidas de la tecnología, y el segundo a finales de los 80’s, que se extendió hasta principios de los 90’s, generado principalmente por los altos costos en los desarrollos y en el sostenimiento de las bases de datos digitales.

A pesar de las innovaciones durante este periodo en el campo de la ingeniería, la medicina fue muy lenta en la adopción de la IA.

Sin embargo, durante este tiempo la digitalización de los datos y el desarrollo de motores de búsqueda basados en la web como Pubmed (creada en 1960), ayudaron a la posterior aceleración de la biomedicina.

Es decir, en esta fase la organización de las bases de informática clínica y de los sistemas de historia clínica electrónica empezaron a establecer la estructura para los desarrollos posteriores de esta área en la medicina (11).

La era de la cosecha de la IA

Como hemos visto los primeros desarrollos en el campo de la IA fueron los llamados sistemas expertos, es decir sistemas con una colección de reglas en los que la inteligencia humana puede ser formalizada y reconstruida a través de un enfoque de arriba hacia abajo mediante un entrenamiento de árbol de decisión.

Estos sistemas funcionan muy bien en áreas de formalización, pero no pueden ejecutar tareas más complejas como interpretación de datos externos, aprendizaje con los mismos y lograr adaptaciones flexibles.

Estas deficiencias llevaron a la generación de las redes neurales artificiales, trabajo iniciado en 1969 cuando Marvin Minsky y Seymour Papert en el MIT demostraron que los computadores no tenían la suficiente capacidad de procesamiento, más allá de dichos sistemas expertos.

Estas redes neuronales artificiales tomarían la forma de aprendizaje profundo en el año 2015 cuando el programa Alpha Go, desarrollado por Google, fue capaz de vencer al campeón mundial del juego de mesa Go, lo cual marcó el primer hito de lo que algunos quieren ver como una competencia entre el humano y la máquina.

Previamente, el programa de IBM, Deep Blue, en 1997 había derrotado al campeón mundial de ajedrez Gary Kasparov, gracias a su capacidad de análisis de 200 millones de posibles movimientos por segundo, entrenado mediante árboles secuenciales de decisión; este a diferencia de Alpha-Go era un sistema experto, no un sistema basado en redes neuronales artificiales.

En el campo médico, hacia el año 1971 se desarrolló por parte de Saúl Amarel en la Universidad de Rutgers el primer modelo para la investigación de computación en biomedicina:

Al cual siguió el desarrollo de un sistema de computación experimental entre la medicina y la IA en la Universidad de Stanford en 1973, lo que permitió expandir las capacidades de red entre los investigadores clínicos y biomédicos de muchas instituciones.

En 1975 se creó el primer Instituto de inteligencia artificial en medicina y se realizó el primer taller sobre el tema en la misma Universidad de Rutgers.

Uno de los primeros prototipos que demostró factibilidad fue el programa para la consulta de glaucoma mediante el modelo CASNET.

Este modelo es una red de asociación causal que tiene tres subprogramas: un modelo de arquitectura, un modelo de consulta y una base de datos que es construida y mantenida por diversos colaboradores.

Este desarrollo, también generado en la Universidad de Rutgers, fue oficialmente demostrado en la reunión de la Academia de Oftalmología en 1976. Este aplicaba información sobre una enfermedad específica a pacientes individuales y les daba a los médicos un soporte para la decisión de tratamiento.

En 1986, DXPlain, un sistema de apoyo a la decisión médica fue lanzado por la Universidad de Massachusetts.

Este programa utilizaba una bolsa de síntomas para generar diagnósticos diferenciales y también servía como un libro electrónico que generaba descripciones detalladas de enfermedades y referencias adicionales.

Al momento de su lanzamiento, el programa era capaz de dar información sobre 500 enfermedades y posteriormente se expandió para cubrir 2.400. La evolución de este tipo de programas llevó a desarrollos más actuales como el de Watson for Oncology de IBM, que será tratado en otros artículos de esta edición especial.

En el año 2007, IBM creó un sistema abierto de pregunta – respuesta al cual llamó Watson.

Este sistema compitió contra el ganador del espectáculo de televisión Jeopardy en 2011 y ganó el primer lugar.

A diferencia de los sistemas tradicionales que utilizaban razonamiento posterior, es decir seguían reglas de datos para llegar a conclusiones, esta tecnología se basaba en el sistema DeepQA ®, que es un procesador de lenguaje natural que utiliza fuentes diversas para analizar datos no estructurados y generar posibles respuestas.

Este sistema era más amigable, fácil de utilizar y mucho más costo efectivo.

Aplicando esta tecnología, en 2017 IBM Watson logró identificar exitosamente nuevas proteínas de fijación al ARN que estaban alteradas en la esclerosis lateral amiotrófica y, posteriormente, desarrollar un programa de soporte al razonamiento clínico en oncología al que llamó Watson for Oncology. Infortunadamente, tuvo mucho menos éxito, a pesar de haber sido “entrenado” por el Memorial Sloan Kettering Cancer Institute en Nueva York.

Para este momento, junto con la mejora en los programas y en la capacidad de computación, la medicina digital parecía hacerse mucho más factible y empezó a crecer con rapidez, especialmente los programas de procesamiento del lenguaje natural y los chat-bots.

En el año 2014 se desarrolló Pharmabot para apoyar a la educación médica en pacientes pediátricos y sus padres, mientras que en 2017 se desarrolló Mandy, una especie de paciente automatizado para la educación en atención primaria (12).

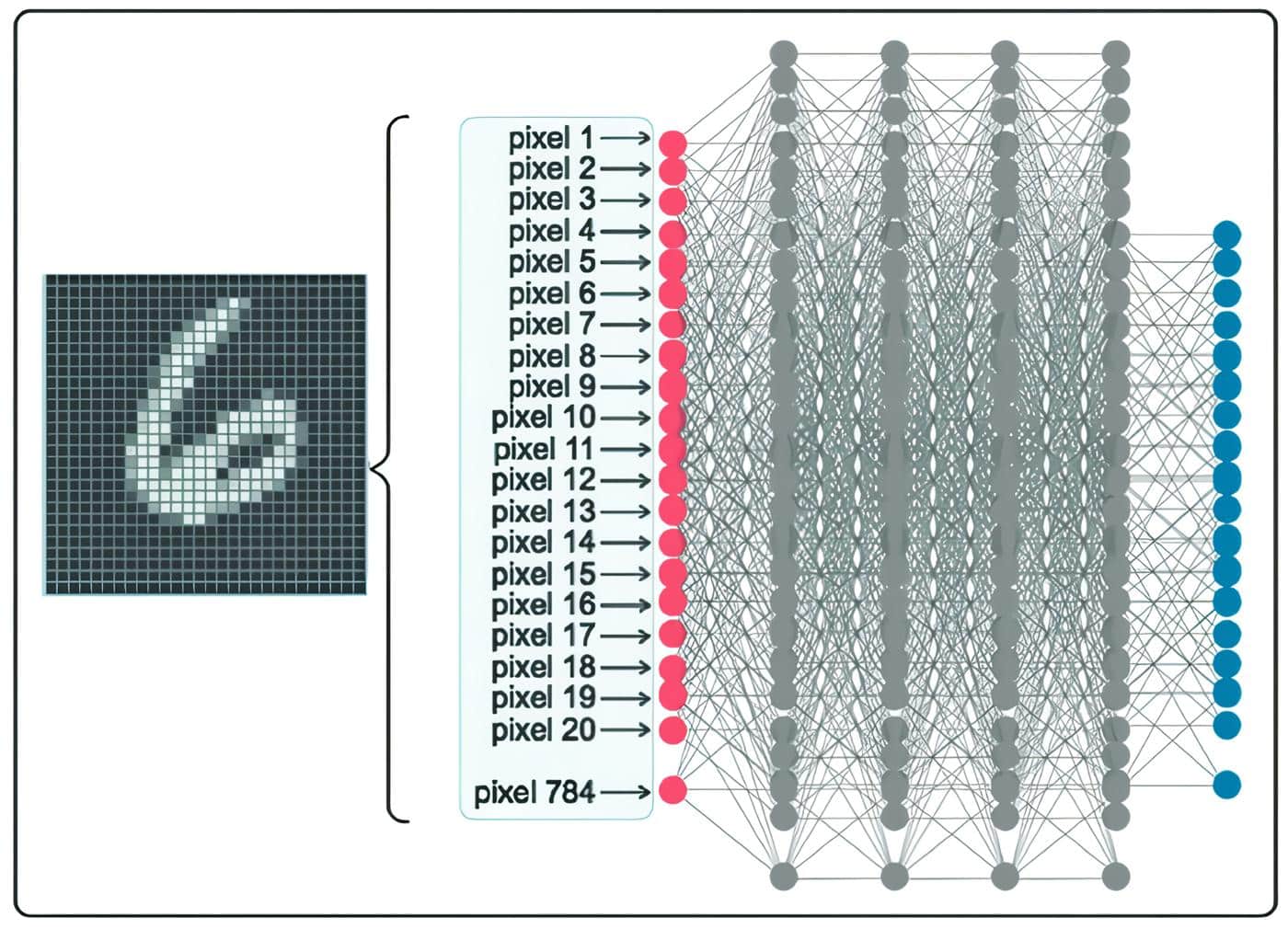

Hasta ese momento los principales desarrollos de la IA en medicina estaban basados en el aprendizaje automatizado o Machine Learning (ML), que utiliza una serie de datos y características para el entrenamiento desarrollado por el humano. Posteriormente, el aprendizaje profundo (AP) o Deep Learning (DL) empezó a tomar relevancia en el campo médico.

El problema del sobreajuste (overfitting) en el AP, efecto que limitaba el procesamiento de datos grandes generando insuficiente capacidad de cómputo y entrenamientos de pobre calidad, logró superarse después del año 2010 con la disponibilidad de mejores sets de entrenamiento de datos y obviamente por una mejor capacidad de computación, lo que llevó a la aplicación de modelos de AP avanzados como las redes neurales recurrentes (RNN) y las redes neurales convolucionales (CNN) en campos como el procesamiento de imágenes.

Estas redes simulan el comportamiento de neuronas interconectadas humanas. Una CNN está compuesta por muchas capas que analizan una imagen fragmentada para reconocer patrones y crear filtros específicos.

El resultado final de estas redes se produce por la combinación de todas las características conectadas en las capas diferentes del modelo, que han llevado en el presente a tener algoritmos aprobados por agencias como la FDA, que permiten optimizar el diagnóstico por imagen en lo que llamamos visión de máquina, entre ellos tenemos: Le-net, Alex-net, DGG GoogleNet y ResNet entre otros (13).

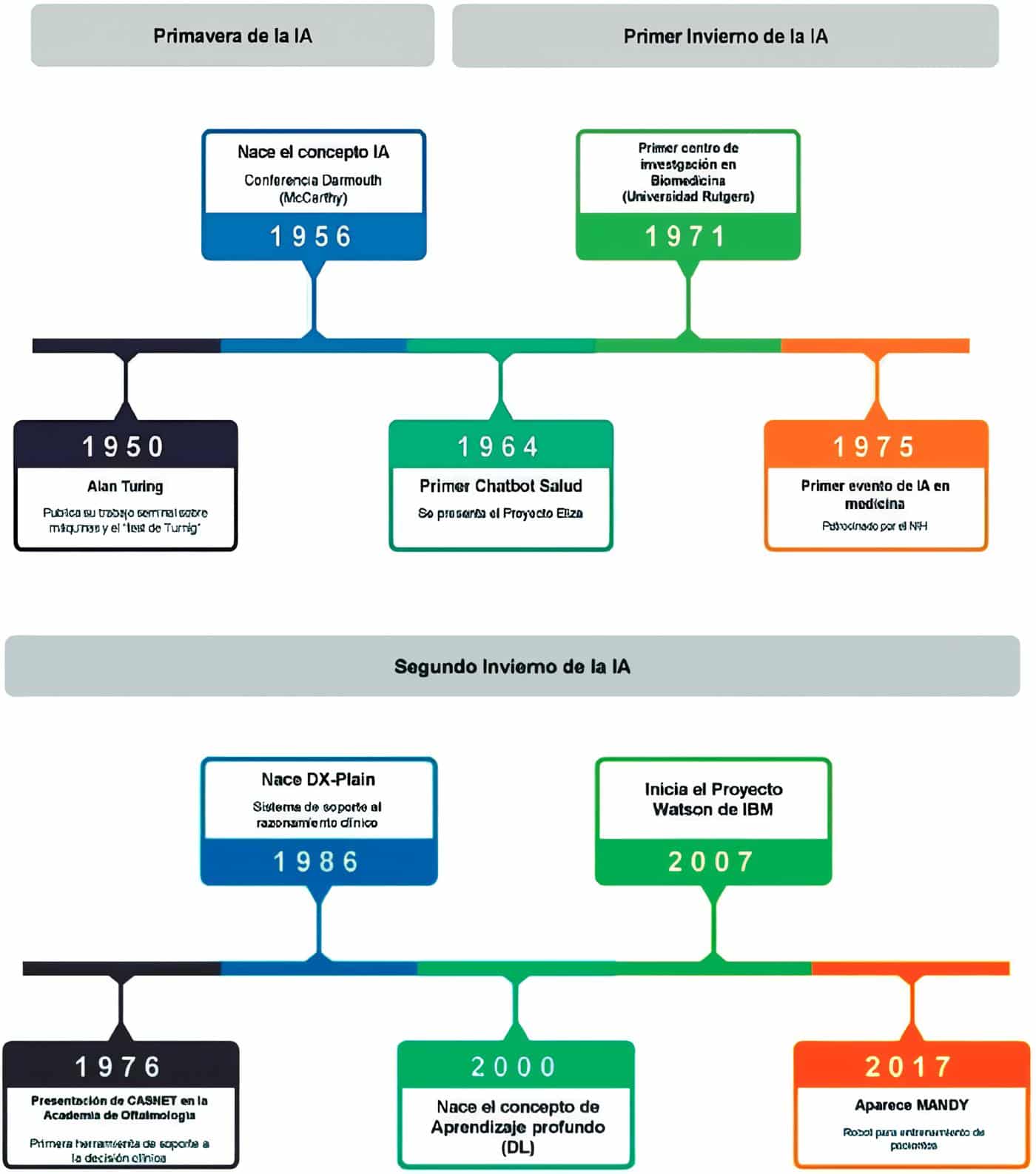

La Figura 2 muestra la línea del tiempo de los desarrollos de IA en medicina más relevantes de la historia.

Figura 2. Línea del Tiempo de la IA en Medicina

Hasta ahora hemos hablado del hardware, esa infraestructura física que al cambiar de engranes a circuitos requirió una supraestructura, una cadena, una secuencia de instrucciones lógicas, algoritmos, diseñadas con base en lenguajes de programación, que permiten al hardware resolver nuestras necesidades o requerimientos mediante una acción que permite la reproducibilidad, a iguales entradas iguales resultados.

Así como la IA tiene subcampos como son el aprendizaje automatizado (AA), el aprendizaje profundo (AP), los procesadores de lenguaje natural NLPs y la visión de máquina CV, los modelos matemáticos y las arquitecturas sobre las cuales se basa, también han tenido una evolución relevante.

Evolución histórica de los modelos de IA

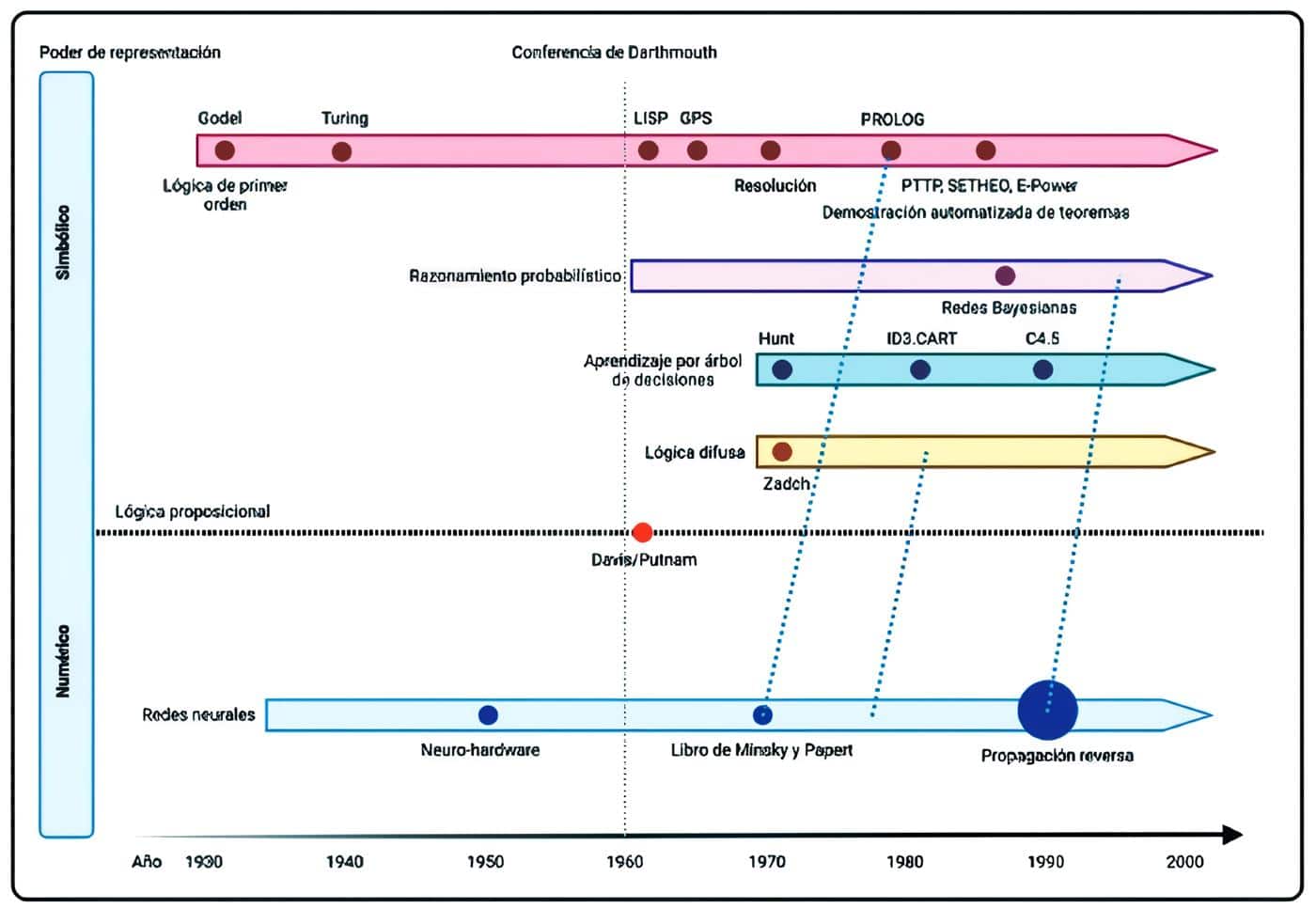

Como se ha mencionado, entre 1930 y 1950 Gödel, Church y Turing sentaron las bases de la IA desde la lógica y la teoría computacional, navegando en el problema de la decidibilidad matemática, con lo cual cubrieron y explicaron los limites formales de los sistemas formales (hoy llamados expertos).

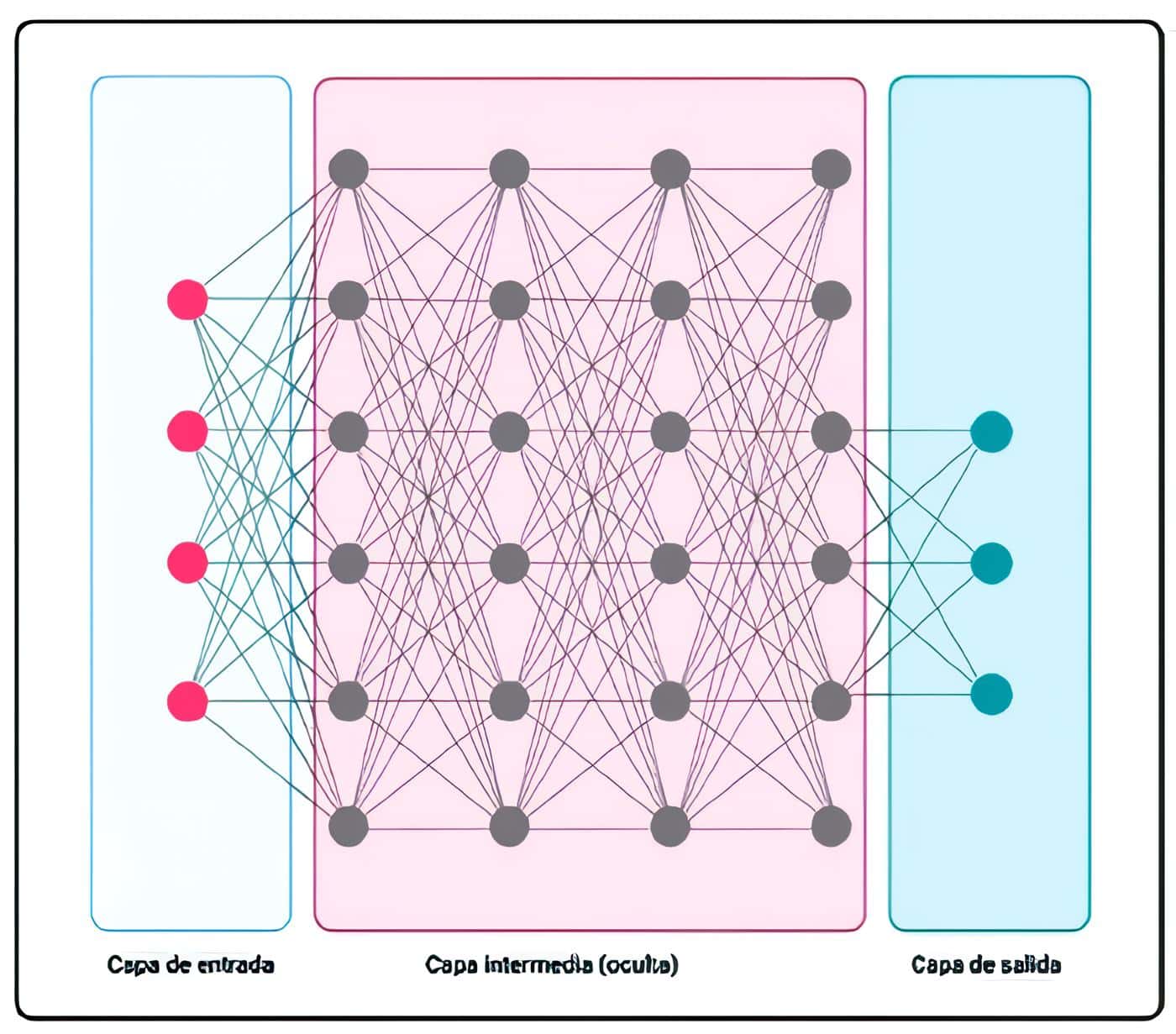

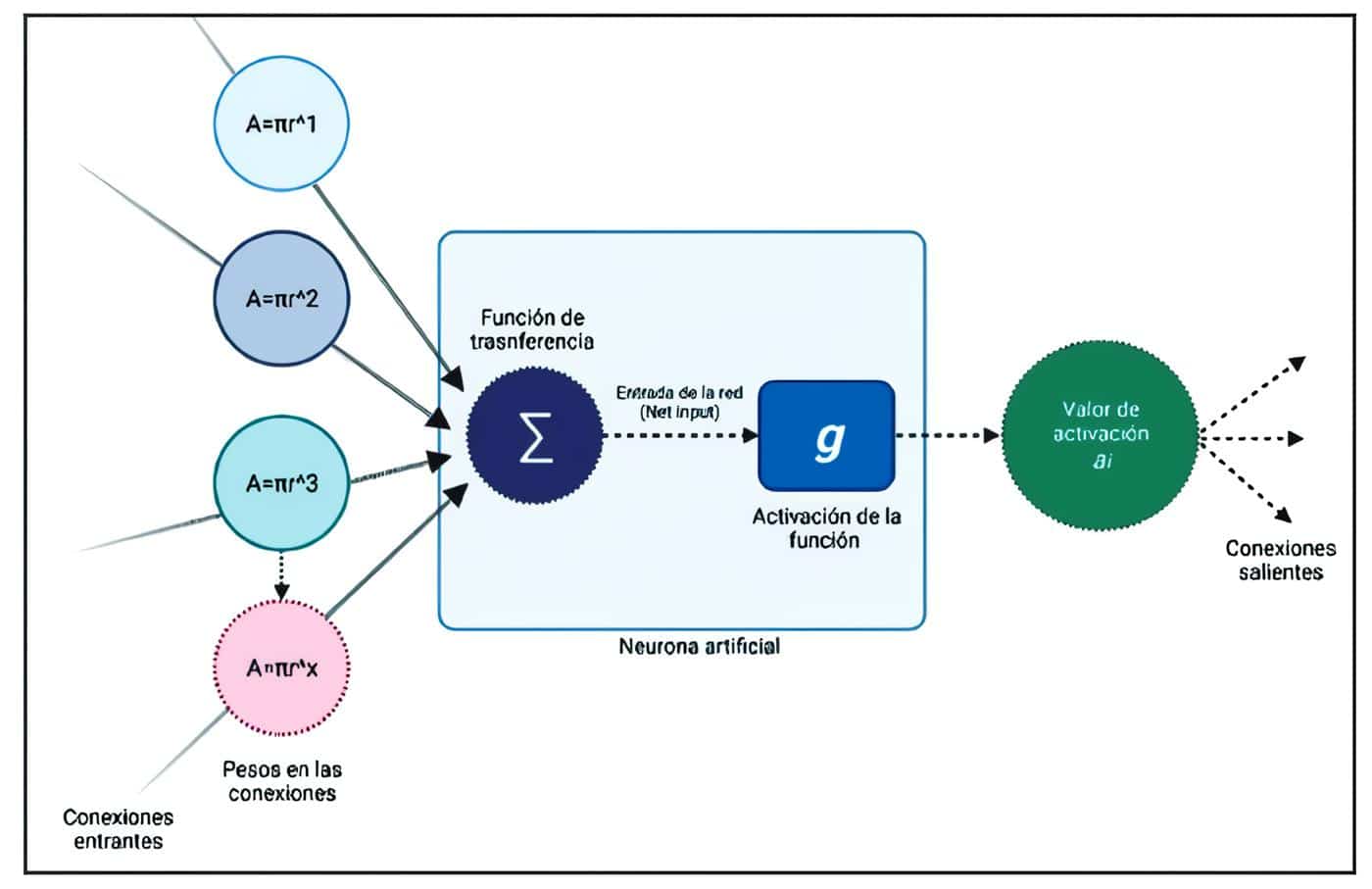

Hacia mediados de 1940 y con base en estas conclusiones, así como en conceptos derivados de la neurociencia, McCulloch, Pitts y Hebb diseñaron el primer modelo matemático de las redes neuronales, el perceptrón.

Sin embargo, dada la limitada capacidad de computación de la época, no pudieron migrar a redes neuronales artificiales (Figura 3).

Figura 3. Modelo Perceptrón (neurona artificial).

En 1950 Newell y Simon introdujeron el concepto de Lógica Teórica, como el primer teorema automático de validación, y con el cual demostraron que los computadores no solo pueden trabajar con números, sino también con símbolos.

Al mismo tiempo McCarthy introdujo el lenguaje LISP, especialmente diseñado para el procesamiento de estructuras simbólicas. Estos dos sistemas fueron presentados en la histórica conferencia de Dartmouth en 1956.

En 1970 el lenguaje de programación lógica PROLOG fue presentado como la contraparte europea del LISP. No obstante, debido a la entrada de la era del invierno de la IA estos sistemas no tuvieron mayor desarrollo.

Durante esta fase de invierno, los científicos empezaron a evaluar tecnologías cognitivas, modelando redes neurales capaces de aprender mediante sets de entrenamiento y hacer tareas que previamente requerían programación costosa.

El sistema Net-Talk por ejemplo, fue capaz de procesar lenguaje natural desde la lectura de textos. A esta fase se le conoce como el conexionismo, que hoy es una subdisciplina de la IA (14).

Aunque en ese momento no se tenía la capacidad de computación para utilizar métodos que gestionaran la incertidumbre informática avanzada, como las redes neuronales, surgieron otras alternativas.

La más prometedora fue el razonamiento probabilístico, dentro de este las redes bayesianas, sobre las cuales se fundamentaron los primeros desarrollos de sistemas expertos, pero dado que la lógica es muy débil al trabajar solo con dos valores verdaderos, otros métodos como el fuzzy logic y otros modelos de probabilidad empezaron a utilizarse.

Posteriormente se desarrollaron los árboles de decisión y los sistemas híbridos que congregaron exitosamente las redes neurales y las metodologías lógicas. Desde 1990 la minería de datos se ha desarrollado como una subdisciplina de la IA en el área de analítica avanzada. La siguiente línea del tiempo resume los desarrollos de la inteligencia artificial desde su abordaje técnico (Figura 4).

Figura 4. Línea del tiempo de los modelos de ML/DL.

La metáfora de la neurona humana y el perceptrón

El modelo de aprendizaje supervisado de una red neuronal se basa en un constructo matemático explicado bajo la metáfora de la fisiología neuronal.

A este constructo matemático se le entregan unas variables de entrada (ejemplo una radiografía de tórax) en forma de un conjunto de números llamados vectores, que extraemos de los datos de entrada, por ejemplo, los píxeles de una imagen o de las bioseñales de un electroencefalograma.

Se le entrega también los datos marcados con el desenlace a predecir (ejemplo presencia o no de neumonía en cada radiografía).

Así, cuando entrenamos la red los datos son procesados por unidades llamadas neuronas, que constan de dos partes, la primera una función de transferencia de pesos (números), y la segunda una función de activación que hace que la neurona transmita los pesos a la siguiente si la sumatoria de todos alcanza un punto de no retorno similar a la ley del todo o nada en el potencial de acción (15) (Figura 5).

Figura 5. Estructura actual de una neurona, función de

transferencia de pesos y función de activación.

La diferencia fundamental entre el modelo del perceptrón y la red neuronal multicapa profunda actual que ha permitido el desarrollo del aprendizaje profundo, es la función de activación (15).

Dado que estas funciones matemáticamente son más exactas que antes al momento de apagar o transmitir los pesos calculados de una neurona a otra.

Esta función de activación es la que rompe la linealidad de los modelos neuronales (sin esta solo serían un conjunto de regresiones lineales simples) al activar o apagar las neuronas según el peso recibido.

Al final, la red entrega una predicción y la compara con el desenlace final, calcula que “tan cerca” estuvo de realizar una predicción (el error) e inicia el proceso de retropropagación, en el que calculando la derivada ajusta los pesos para recalcularlos y buscar un error menor.

Este proceso se repite hasta encontrar el error mínimo entre la predicción y el desenlace por medio de un proceso matemático llamado gradiente del descenso.

En los últimos años, el desarrollo de las redes neuronales ha tenido impacto en medicina, especialmente en áreas en las que la visión computacional juega un papel importante.

El mayor avance se ha dado en la creación de nuevas arquitecturas, es decir, la forma en que se conectan unas neuronas con otras.

Por ejemplo, la redes convolucionales que permiten mejores predicciones en imágenes o las redes recurrentes y las redes tipo Transformers que han permitido el desarrollo de modelos de predicción más exactos en datos secuenciales como el procesamiento natural del lenguaje (16).

También la capacidad de procesamiento juega un papel importante, es decir, la cantidad de cálculos que puede realizar un computador al mismo tiempo -dado que estos modelos realizan miles de cálculos simultáneos- lo que hace que estos modelos sean computacionalmente costosos y las unidades de procesamiento alterna como las tarjetas de video sean especialmente útiles para esta tarea (15).

Ahora, en la época de potentes y veloces procesadores (hardware, computación cuántica, super semiconductores), evolucionados y complejos softwares:

Permiten condensar a través de esta combinación la posibilidad de que una tecnología basada en el silicio simule la tecnología basada en el carbono, capaz de aprender, desaprender, realizar cálculos simples, complejos, construir modelos tridimensionales, integrando la capacidad de predecir con base en su aprendizaje de millones de datos secuenciales o en paralelo, aumentando la inteligencia humana y dando paso a un coeficiente intelectual exponencial con múltiples aplicaciones.

Entre ellas la ciencia de diagnosticar, tratar y en ocasiones curar las enfermedades, y con base en la gran capacidad de procesamiento de la información, predecir la ocurrencia de una enfermedad y la respuesta a los tratamientos (Figura 6).

Figura 6. Ejemplo de red uni-capa para reconocimiento de números.

¿Es esto una pérdida del arte de la medicina?

Para los románticos la respuesta es no, es una evolución, un paso, que la inteligencia artificial a través de la optimización de procesos, tiempos y movimientos nos permitirá girar en torno a las personas.

Irónicamente, aquello que nos trae el temor de la irrelevancia nos transportará a ser mejores humanos y posiblemente mejores médicos.

Referencias – Del Ábaco a las Redes Neuronales o la Breve Historia de la Inteligencia Artificial en Salud

1. Nebel S. Animal Migration. Nature Education Knowledge. 2010;10(3):77.

2. Handbook on climate information for farming communities. Roma:FAO; 2019.

3. Quipu Incan Counting Tool [Internet]. Encyclopedia Britannica.2021 [consultado 23 julio 2021] Disponible en: https://www.britannica.com/technology/quipu.

4. Ascher M., Ascher R., Mathematics of the Incas: Code of Quipu. Nueva York: Dover Publication; 1997.

5. Garrido C. Historia de la Computación. [Tesis maestría]. Universidad de San Carlos de Guatemala; 2008.

6. Haenlein M, Kaplan A. A brief History of Artificial Intelligence: On the Past, Present, and Future of Artificial Intelligence. California Management Review. 2019;61(4):5-14.

7. Buchanan B. A (Very) Brief History of Artificial Intelligence. AI Mag [Internet].2005 [consultado 23 julio 2021];26(4):53. Disponible en: https://ojs.aaai.org/index.php/aimagazine/article/view/1848

8. AIpocrates [Internet] AIpocrates.org. 2021.[consultado 23 julio 2021]. Disponible en: www.Aipocrates.org.

Bibliografías – Del Ábaco a las Redes Neuronales o la Breve Historia de la Inteligencia Artificial en Salud

9. Hawking S. Dios Creó los Números. . 1ra edición. Barcelona: Crítica; 2006..

10. Kleinrock L. An Early History of Internet. IEEE Communications Magazine. 2010;48(8):26-36.

11. Kaul V, Enslin S, Gross S.. History of artificial intelligence in medicine. Gastrointest Endosco. 2020;92(4):807-812.

12. Ni L, Lu C, Liu N, Liu J. Mandy: towards a smart primary care chatbot application. Comms Computer Informat Science. 2017;38-52.

13. The Medical Futurist.[Internet]. The Medical Futurist. 2021 [consultado 28 septiembre 2021]. Disponible en: https://medicalfuturist.com/

14. Ertel W. Introduction to Artificial Intelligence. Nueva York: Springer; 2011.

15. Ketkar N. Deep Learning with Python .Berkeley: Springer, 2017.

16. Artificial Intelligence in Healthcare . 2020.

17. Looking inside neural nets [Internet]. MI4a.github.io.2021 [consultado 4 de octubre de 2021]. Disponible en: https://ml4a.github.io/ml4a/looking_inside_neural_nets/

Autores – Del Ábaco a las Redes Neuronales o la Breve Historia de la Inteligencia Artificial en Salud

1 Luis Eduardo Pino V, Andrés Eduardo Rico-Carrillo, Alejandro Hernández-Arango, MD, MSc, MBA. Miembro Fundador de AIpocrates.

2 Departamento de Oncología Clínica, Instituto de Oncología, Fundación Santa Fe de Bogotá, Bogotá, Colombia

3 Luis Eduardo Pino V. MAIA Healthcare y MedzAIo, Bogotá, Colombia

4 Andrés Eduardo Rico-Carrillo, Departamento de Medicina Interna, Fundación Javeriana de Servicios Médicos y Odontológicos Interuniversitarios “Carlos Márquez Villegas” JaveSalud IPS, Bogotá

5 Alejandro Hernández-Arango, Departamento de Medicina Interna, Universidad de Antioquia, Medellín, Colombia

6 Alejandro Hernández-Arango, Maestría Telesalud, Facultad de Medicina, Universidad de Antioquia, Medellín, Colombia

Recibido: 12 de Noviembre, 2021

Aceptado: 22 de Noviembre, 2021

Correspondencia:

Luis Eduardo Pino V.

docpino2@gmail.com